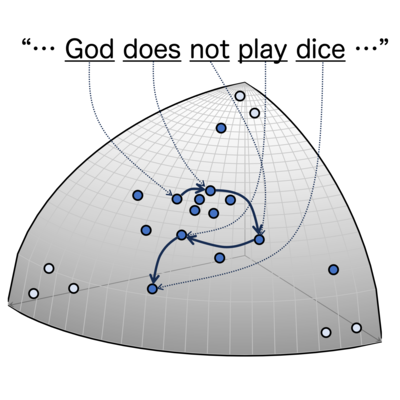

自然言語の相関次元は、大規模言語モデルによって生成された高次元ベクトル列にGrassberger-Procacciaアルゴリズムを適用することで測定されます。この方法は、以前はユークリッド空間でのみ研究されていましたが、本研究では、統計多様体上にFisher-Rao距離を用いて再定式化しました。相関次元は、普遍的に約6.5であることがわかりました。この値は単純な離散ランダム列のそれよりも小さく、Barabási-Albert過程のそれよりも大きいです。 参考文献

Renyiエントロピー

2 Articles

2

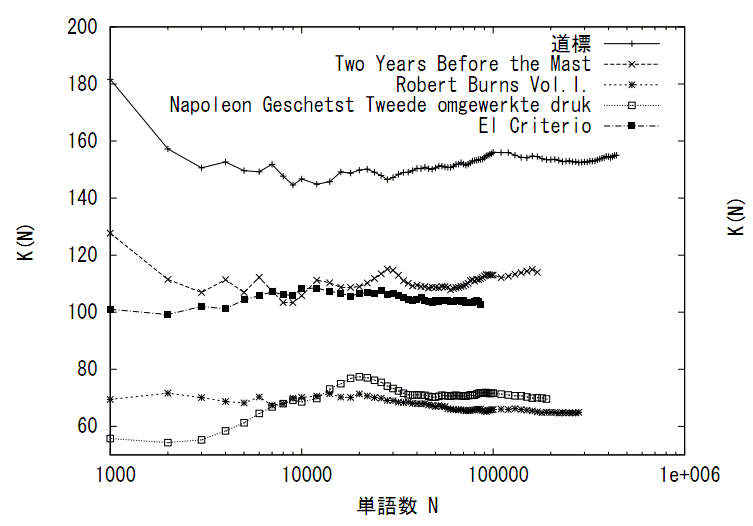

様々な種類のデータに対して様々な統計量が数理的に考察されてきました。自然言語のテキストに対しては著者や言語種、ジャンルなど、その種類を量的に峻別する統計量とは何かが考えられてきました。例えば統計学者Yuleが提案したKがその一つで、これはRenyiの2次エントロピーと等価です。YuleのKはデータ量に依存しない統計量となっており、データの性質を安定的に表す統計量となっています。研究室では、データのスケーリング則との関連をふまえ、このような統計量として何があるかを探究しています。 参考文献