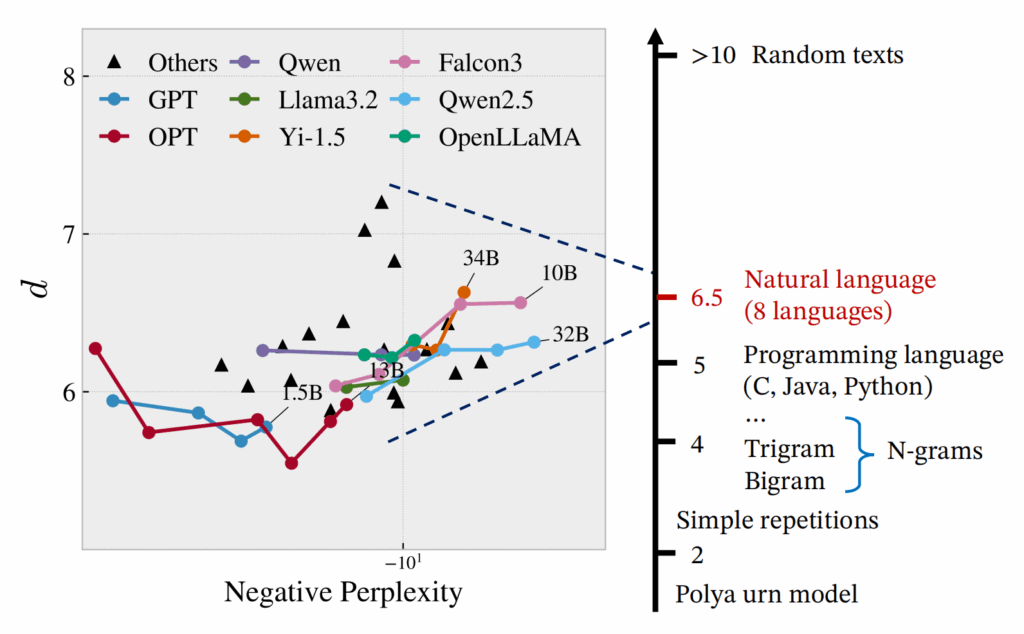

大規模言語モデル(LLM)は自然言語生成において顕著な進歩を遂げている一方で、パープレキシティが低い場合であっても、反復や文のちぐはぐさといった不可解な挙動を依然として示す。このことは、局所的な予測精度を重視するあまり長距離の構造的複雑さを見落としてしまうという、従来の評価指標の本質的な限界を浮き彫りにしている。本研究では、自己相似性を測るフラクタル幾何学的な尺度である「相関次元」を導入し、言語モデルの観点から知覚されるテキストの認識論的複雑さを定量化する。この指標は、言語の階層的な再帰構造を捉えることで、局所的および大域的な性質を統一的な枠組みのもとで橋渡しする役割を果たす。大規模な実験を通じて、相関次元が (1) 事前学習過程における3つの異なるフェーズを明らかにし、(2) 文脈依存的な複雑さを反映し、(3) モデルのハルシネーション傾向を示唆し、さらに (4) 生成テキストに現れる複数のデジェネレーション形態を高い信頼性で検出できることを示す。我々の手法は計算効率に優れ、4ビット精度までのモデル量子化に対しても頑健であり、Transformer や Mamba をはじめとする広範な自回帰アーキテクチャに適用可能である。また、LLM の生成ダイナミクスに対して新たな洞察を提供する。

参考文献

Du, X., & Tanaka-Ishii, K. (2025). Correlation Dimension of Auto-Regressive Large Language Models. arXiv preprint arXiv:2510.21258.[arxiv]